AIはChatGPT、Google Gemini, Copilot, Claude …など既に

多くのAIがあり多くのソフトウェア製品にもバンドルされているし

企業法人でも自社サーバーにAIを導入するという動きが出ている。

このAIを社内に導入するという話をよく聞くようになったが

それではAIを社内に導入するとは一体どういうことをするのだろうか?

またAIを社内に導入するメリットは何だろうか?

下記の紹介は莫大な時間をかけてAIから聞き出したものであるが

AIはまだまだ表現が下手な上に文章に条件が不足していたり

誤った内容を伝えてから何度でも訂正するという間違いを

数多くする。

つまりAIはいつでも論理的で正確というわけではない。

AIの言うことを正しく聞き出すのは本当に大変なことである。

定義していない新規の用語を使ったり同じ用語を

またちがった言葉で表現したりとか論理性をたびたび注意しないと

正確な内容を聞き出すことができない。

さっき言った話とはちがうではないかという間違いを

何度でも繰り返す。

基本的な論理思考がまだまだのようであるAIは出来の悪い社員のようで

人間なら20分くらいでできることを3時間もかかってもまだ間違いを

新たに繰り返す鈍用さにあきれたことがある。

シンギュラリティ(Singularity)という技術的特異点が今すぐにでも来て

人間の知性が追い抜かれると言われているが現実はそうでもなくて

むしろ今は失望期に入っているとも言われている。

ただインターネット公開情報を調べたり単純な変換は

まだ正確ではないもののやはり驚くほど速いので利用する価値はある。

さてChatGPTやGeminiなどの莫大なAIそのものを

自社サーバーに導入することは現在、サポートされていないし

できない。

それではなぜ自社サーバーにAIを導入するという話が

出るのかというとそれはAIの機能の一部である。

ダウンロードしてローカルPCやローカル・サーバーに

導入できるのは大きく分けて次の二つのモジュールである。

■ AIを構成するふたつのモジュール

①LLMサーバー(大規模言語モデル)

LLMサーバーというのはAIの思考回路そのものである。

AIのすべての記憶や知識ではないがAIの考える能力そのものを

ローカル・サーバーに導入することができる。

これがAIの考える部分であり思考回路そのものである。

ただしLLMサーバーの力を発揮させるには

ローカル・サーバーと言えどもメモリーは32GB以上の

CPUではなくGPUの搭載が必要であり

そのようなサーバーは百万円以上のPCサーバーが

必要となる。( GPU(Graphics Processing Unit)は、画像や映像の描画に特化した高速演算装置のことである )

②推論サーバー

推論サーバーというのは言葉として良くないのだが

LLMのインターフェースとなる言語中枢の処理を

成す部分のモジュールである。

現在、私は日本語でAIと対話しているが

恐らく米国人が対話しているChatGPTも

私が対話しているのと同じChatGPTだろう。

ちがうのはこの言語処理インターフェースである

推論サーバーである。

推論サーバーがLLMが考えたことを日本語に翻訳して

私と会話しているはずである。

推論サーバーの実行プラットフォームにはLLMほど

大規模な環境は必要なくWindowsPCでも十分実行可能である。

さて企業のローカルに導入するというのは

この

①LLMサーバー(大規模言語モデル) と

②推論サーバー

の両方をローカル環境に導入することができる。

LLMサーバー

(考えるのが専門の大規模言語モデル)

推論サーバー

(LLMが考えたことを言葉にして表現する)

LLMサーバーが大脳の思考回路であり推論サーバーが

言語中枢である。人間ならばこのように第三者にもわかりやすい

表現ができるかAIそのものは適切な比喩表現が下手くそであり

まだ人間に及ぶところではない。

両方を導入すればインターネット接続のないオフ・ライン環境でも

AIとして使うことができるしこの中で独自の教育ができる。

ただしローカルにダウンロードしたLLMサーバーは本来のAIの

一部の機能でしかないので基本となる知識に欠ける場合が

あるかもしれない。

けれどもAIに独自の教育をして成長させたいときは

やはりローカルにLLMサーバーを導入する必要がある。

①のLLMサーバーにはいろいろなAIのLLMを

ダウンロードしておいて②の推論サーバーで

切り替えて使うこともできる。

そのため②推論サーバーは多くの種類が公開されていて

推論サーバーから①のLLMに対してREST APIなどで

アクセスを切り替えて使うことができるようになっている。

| 名前 | 難易度 | GPU必要 | API提供 | 用途 |

|---|---|---|---|---|

| Ollama | 低 | 任意 | あり | 小規模 |

| LM Studio | 低 | 任意 | あり | 開発 |

| WebUI | 中 | 任意 | あり | 研究 |

| vLLM | 高 | 推奨 | あり | 高速処理 |

ただしこれらの推論サーバーはローカルLLMサーバーとの

連携を前提としている。

①LLMサーバー と

②推論サーバー

との使い方は両方ともローカルにダウンロードして使うのではなく

①はクラウドLLMサーバーつまり既存のクラウドAIモデルと連携する

②ローカル推論サーバー

という構成も可能である。

推論サーバーをローカルに置くメリットは推論サーバーから

ユーザー・コーディングの外部プログラムと連携して

IFSアクセスが可能になることである。

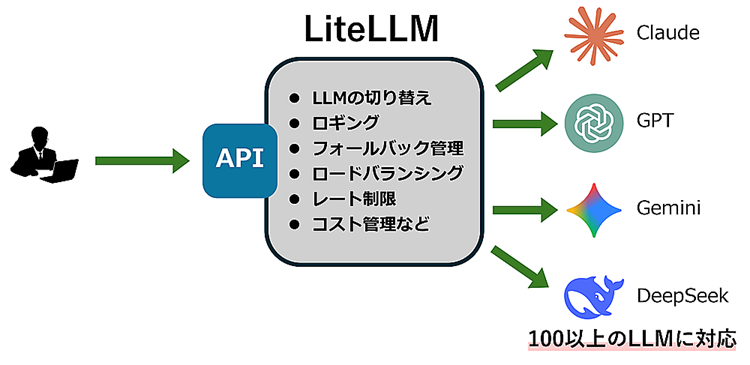

■ LiteLLM : AIゲートウェイ

このように②ローカル推論サーバーとしてクラウドのAIモデルと

対話が可能な推論サーバーであれば現存するAIモデルと

連携できるので最新の知識や情報に基づくAIモデルを

利用することができる。

しかも複数のAIモデルをユーザーの希望に応じて切り替えて

使うことができる。

このようなクラウド連携型推論サーバーのことを

AIゲートウェイと呼ぶ。

AIゲートウェイであれば社内に大規模なGPUを要するLLMサーバーを設置する必要もないし

外部のクラウドAIモデルを選択して使用することができるので

最新の教育されたAIモデルを無料で使うことができる。

このAIゲートウェイの中でもオープン・ソースで最も普及している

AIゲートウェイに「LiteLLM」という名前のフリー・ソフトがある。

このLiteLLMというのはPythonで書かれていてPython3.8以上で

動作することになっている。

■ IBM i上でAIが動作できるか ?!

以前にも紹介したように弊社ではPASE環境でPythonの動作に成功して

Pythonの独自のライブラリーも保有している。

しかもこのLiteLLMはPythonライブラリーとして使うことができるので

Pythonプログラムからの呼出しが可能である。

このことは何を意味するかと言うとIBM iにローカル推論サーバーを直接

組み込むことが可能ということでありこれはさらに

IBM iからどのAIでも使うことができるようになるということである。

■ AIも驚いたIBM iのイノベーション

ChatGPTはIBM iにはまだ誰もLiteLLMを置いた実績はないと言ったが

独自のPythonライブラリーもIBM i上で作った実績があると

言ってやるとGPTは初めて実現できる可能性があると

非常に驚いて感動していた。

まさにAIも驚くイノベーションとなるに違いない。

例えばIBM i上でAIを使ってRPGソースを生成して

直接QRPGLESRC上にRPGソースを出力して生成することもできる。

既にある弊社の技術を組み合わせるだけで

IBM iでのAIの直接利用ができるということになる。

間接的なコピー&ペーストではなくIBM i内部で

AIを起動してAIとIBM iが対話できるということである。

IBM iの5250エミュレータからChatGPTにRPGを作らせることもできるし

CopilotにDSPFソースを作らせることも問題なくできる。

将来のIBM i開発は日本語ですることになりそうである。

もちろんAIによる解析もお手の物で高価な文書化ソフトなど必要ない。

AIが社内のプログラムを解析して問題点と改善すべき点も

報告してくれるようになるだろう。

弊社では以前よりPythonを開発中であり現在は

文書化も終えてホーム・ページの記事の作成を

残すのみである。新しい技術の吸収は次の新たな技術を

生むことにつながることになる。

IBM i上でAIが躍動することになる日も遠くはない。